scala

[spark] Spark Streaming Job 모니터링 중요한 부분

'김용환'

2019. 10. 31. 08:52

Spark Streaming Job(Kafka-Consumer)의 성능을 높일 수 있다.

* Kafka topic의 파티션 개수 * 설정 파일의 spark.streaming.kafka.maxRatePerPartition 이다.

* 파티션 개수가 10개 * spark.streaming.kafka.maxRatePerPartition이 5 개이면 => 50 event /duration 성능이 나온다.

그러나 maxRatePerPartition이 너무 크면 OOM이 발생하거나 스트리밍 시스템(sink)에 영향을 줄 수 있다.

스트리밍이 제대로 동작되는지 확인하려면 2가지를 확인할 수 있다.

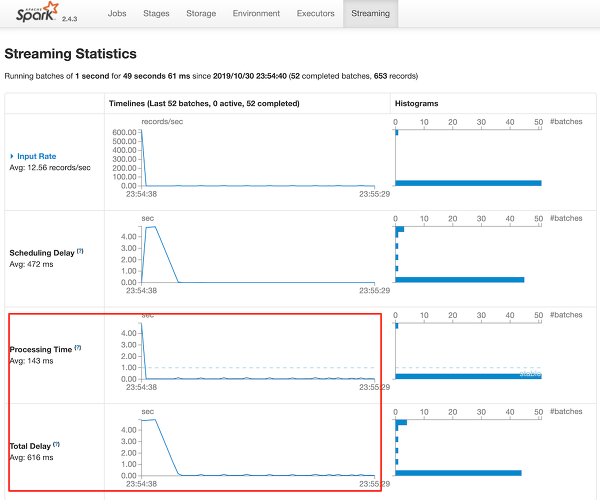

1) 52 completed batches, 653 records (동작안되면 0 completed batches 라고 뜬다)

2) Processing Time과 Total Delay 처리 Avg 시간을 확인한다. -로 나온다면 처리하는 것이 아니다.